Publicado em 14 de maio de 2024 e atualizado pela última vez em 20 de maio de 2024

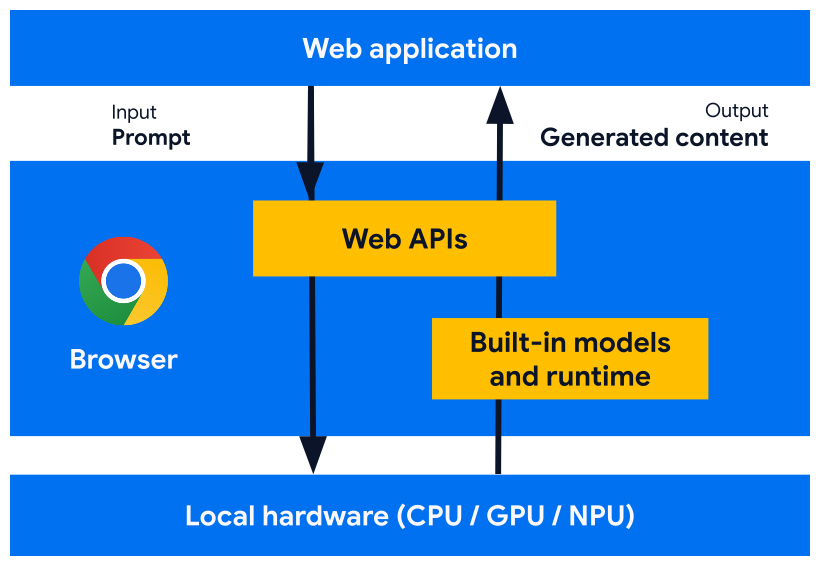

Estamos desenvolvendo APIs de plataforma da Web e recursos de navegador projetados para funcionar com modelos de IA, modelos especializados e modelos de linguagem grandes (LLMs), criados no navegador. Com a IA integrada, seu site ou aplicativo da Web pode realizar tarefas com tecnologia de IA sem precisar implantar, gerenciar ou auto-hospedar modelos.

Descubra os benefícios da IA integrada, nosso plano de implementação e como começar a usar essas ferramentas.

Se você não conhece a IA na Web, leia nosso glossário e conceitos de IA na Web.

Benefícios da IA integrada para desenvolvedores da Web

Com a IA integrada, seu navegador fornece e gerencia modelos fundamentais e especializados.

A IA integrada oferece os seguintes benefícios:

- Facilidade de implantação: o navegador distribui os modelos, considerando a capacidade do dispositivo, e gerencia as atualizações. Isso significa que você não é responsável por baixar ou atualizar modelos grandes em uma rede. Você não precisa resolver problemas de remoção de armazenamento, cota de memória de tempo de execução, custos de veiculação e outros desafios.

- Acesso à aceleração de hardware: o tempo de execução de IA do navegador é otimizado para aproveitar ao máximo o hardware disponível, seja com GPU, NPU ou voltando para a CPU. Como resultado, seu app pode ter o melhor desempenho em cada dispositivo.

Benefícios da execução do lado do cliente

Com a IA integrada, você pode realizar IA do lado do cliente, o que significa que você tem estes benefícios:

- Tratamento local de dados sensíveis: a IA do lado do cliente pode melhorar sua história de privacidade. Por exemplo, se você trabalha com dados sensíveis, pode oferecer recursos de IA aos usuários com criptografia de ponta a ponta.

- Experiência do usuário rápida: em alguns casos, abandonar a viagem de ida e volta ao servidor significa oferecer resultados quase instantâneos. A IA do lado do cliente pode ser a diferença entre um recurso viável e uma experiência do usuário abaixo do ideal.

- Mais acesso à IA: os dispositivos dos usuários podem assumir parte da carga de processamento em troca de mais acesso a recursos. Por exemplo, se você oferece recursos premium de IA, pode mostrar uma prévia deles com IA do lado do cliente para que os clientes em potencial vejam os benefícios do seu produto sem custo adicional para você. Essa abordagem híbrida também pode ajudar a gerenciar os custos de inferência, principalmente em fluxos de usuários usados com frequência.

- Uso da IA off-line: seus usuários podem acessar recursos de IA mesmo sem conexão de Internet. Isso significa que seus sites e apps da Web podem funcionar como esperado off-line ou com conectividade variável.

IA híbrida: do lado do cliente e do servidor

Embora a IA do lado do cliente possa lidar com uma grande variedade de casos de uso, alguns exigem suporte do lado do servidor. A IA do lado do servidor é uma ótima opção para modelos grandes e pode oferecer suporte a uma variedade maior de plataformas e dispositivos.

Considere uma abordagem híbrida se o aplicativo exigir:

- Complexidade:casos de uso específicos e acessíveis são mais fáceis de oferecer suporte com a IA no dispositivo. Para casos de uso complexos, considere a implementação do lado do servidor.

- Resiliência: use o lado do servidor por padrão e o dispositivo quando ele estiver off-line ou com uma conexão instável.

- Fallback elegante: a adoção de navegadores com IA integrada vai levar tempo, alguns modelos podem não estar disponíveis, e dispositivos mais antigos ou menos potentes podem não atender aos requisitos de hardware para executar todos os modelos de maneira ideal. Ofereça IA do lado do servidor para esses usuários.

Por exemplo, se você usar a API Prompt integrada, ela só estará disponível em extensões do Chrome no Windows, macOS e Linux. Para garantir que todos os usuários possam aproveitar o recurso de IA, configure uma arquitetura híbrida com o Firebase AI Logic.

Acessar a IA integrada

É possível acessar os recursos de IA integrados principalmente com APIs de tarefas, como a API Translator ou a API Summarizer. As APIs de tarefa são projetadas para executar a inferência no melhor modelo para a atribuição, seja um modelo de linguagem ou especializado.

Quando usar a IA integrada

Confira algumas maneiras como a IA integrada pode beneficiar você e seus usuários:

- Consumo de conteúdo aprimorado com IA: incluindo resumo, tradução, categorização, caracterização e como um provedor de conhecimento.

- Criação de conteúdo com suporte de IA: como assistência de escrita, revisão, correção gramatical e reformulação.

Várias das APIs de IA integradas estão disponíveis no Chrome Stable e em testes de origem. As APIs exploratórias e em estágio inicial estão disponíveis para participantes do Programa de prévia antecipada (EPP).

Conhecer novos recursos

Precisamos da sua opinião para moldar as APIs e ajudar a atender aos seus casos de uso, além de informar nossas discussões com outros fornecedores de navegadores para padronização.

Participe do EPP para dar feedback sobre ideias de IA integradas em estágio inicial e descobrir oportunidades de testar APIs em andamento usando prototipagem local.

Esforço de padronização

Estamos trabalhando para padronizar todas essas APIs para compatibilidade entre navegadores.

A API Language Detector e a API Translator foram adotadas pelo W3C WebML Working Group (em inglês). Pedimos à Mozilla e ao WebKit as posições deles sobre padrões.

A API Summarizer, a API Writer e a API Rewriter também foram adotadas pelo W3C WebML Working Group. Pedimos à Mozilla e ao WebKit as posições deles sobre padrões.