Dipublikasikan: 14 Mei 2024, Terakhir diperbarui: 20 Mei 2024

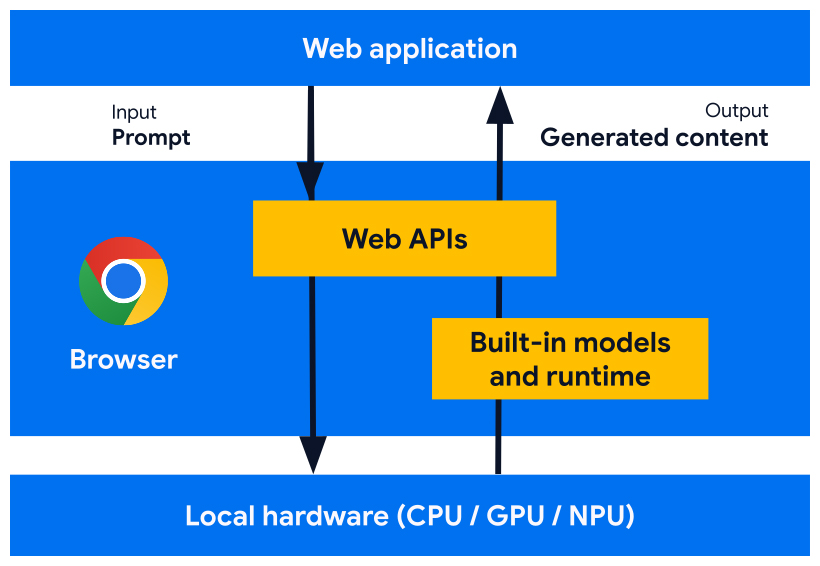

Kami mengembangkan API platform web dan fitur browser yang dirancang untuk bekerja dengan model AI, model pakar, dan model bahasa besar (LLM), yang dibuat di browser. Dengan AI bawaan, situs atau aplikasi web Anda dapat melakukan tugas yang didukung AI, tanpa perlu men-deploy, mengelola, atau menghosting sendiri model.

Temukan manfaat AI bawaan, rencana penerapan kami, dan cara Anda mulai menerapkan alat ini.

Jika Anda baru menggunakan AI di web, baca glosarium dan konsep AI web kami.

Manfaat AI bawaan untuk developer web

Dengan AI bawaan, browser Anda menyediakan dan mengelola model dasar dan pakar.

AI bawaan menawarkan manfaat berikut:

- Kemudahan deployment: Browser mendistribusikan model, dengan mempertimbangkan kemampuan perangkat, dan mengelola update. Artinya, Anda tidak bertanggung jawab untuk mendownload atau mengupdate model besar melalui jaringan. Anda tidak perlu menyelesaikan masalah pengusiran penyimpanan, anggaran memori runtime, biaya penayangan, dan tantangan lainnya.

- Akses ke akselerasi hardware: Runtime AI browser dioptimalkan untuk memanfaatkan hardware yang tersedia secara maksimal, baik dengan GPU, NPU, atau kembali ke CPU. Oleh karena itu, aplikasi Anda dapat memperoleh performa terbaik di setiap perangkat.

Manfaat menjalankan sisi klien

Dengan AI bawaan, Anda dapat melakukan AI sisi klien, yang berarti Anda mendapatkan manfaat berikut:

- Pemrosesan data sensitif secara lokal: AI sisi klien dapat meningkatkan kualitas cerita privasi Anda. Misalnya, jika Anda bekerja dengan data sensitif, Anda dapat menawarkan fitur AI kepada pengguna dengan enkripsi menyeluruh.

- Pengalaman pengguna yang cepat: Dalam beberapa kasus, tidak perlu melakukan perjalanan pulang pergi ke server berarti Anda dapat menawarkan hasil yang hampir instan. AI sisi klien dapat menjadi perbedaan antara fitur yang layak dan pengalaman pengguna yang kurang optimal.

- Akses yang lebih besar ke AI: Perangkat pengguna Anda dapat menangani sebagian beban pemrosesan sebagai imbalan atas akses yang lebih besar ke fitur. Misalnya, jika Anda menawarkan fitur AI premium, Anda dapat melihat pratinjau fitur ini dengan AI sisi klien sehingga calon pelanggan dapat melihat manfaat produk Anda, tanpa biaya tambahan bagi Anda. Pendekatan hibrida ini juga dapat membantu Anda mengelola biaya inferensi, terutama pada alur pengguna yang sering digunakan.

- Penggunaan AI offline: Pengguna Anda dapat mengakses fitur AI meskipun tidak ada koneksi internet. Artinya, situs dan aplikasi web Anda dapat berfungsi seperti yang diharapkan secara offline atau dengan konektivitas yang bervariasi.

AI Hybrid: Sisi klien dan sisi server

Meskipun AI sisi klien dapat menangani berbagai kasus penggunaan, beberapa kasus penggunaan memerlukan dukungan sisi server. AI sisi server adalah opsi yang bagus untuk model besar, dan dapat mendukung berbagai platform dan perangkat.

Anda dapat mempertimbangkan pendekatan hybrid jika aplikasi Anda memerlukan:

- Kompleksitas: Kasus penggunaan yang spesifik dan mudah dipahami lebih mudah didukung dengan AI di perangkat. Untuk kasus penggunaan yang kompleks, pertimbangkan penerapan sisi server.

- Ketahanan: Gunakan sisi server secara default, dan gunakan di perangkat saat perangkat offline atau koneksi tidak lancar.

- Penggantian yang lancar: Penggunaan browser dengan AI bawaan akan membutuhkan waktu, beberapa model mungkin tidak tersedia, dan perangkat yang lebih lama atau kurang canggih mungkin tidak memenuhi persyaratan hardware untuk menjalankan semua model secara optimal. Menawarkan AI sisi server untuk pengguna tersebut.

Misalnya, jika Anda menggunakan Prompt API bawaan, API hanya tersedia di Ekstensi Chrome, di Windows, macOS, dan Linux. Untuk memastikan semua pengguna Anda dapat memanfaatkan fitur AI, siapkan arsitektur hybrid dengan Firebase AI Logic.

Mengakses AI bawaan

Anda dapat mengakses kemampuan AI bawaan terutama dengan API tugas, seperti Translator API atau Summarizer API. Task API dirancang untuk menjalankan inferensi terhadap model terbaik untuk tugas, baik model bahasa maupun model pakar.

Kapan harus menggunakan AI bawaan

Berikut beberapa cara AI bawaan dapat bermanfaat bagi Anda dan pengguna Anda:

- Konsumsi konten yang ditingkatkan AI: Termasuk ringkasan, terjemahan, kategorisasi, karakterisasi, dan sebagai penyedia pengetahuan.

- Pembuatan konten yang didukung AI: Seperti bantuan penulisan, pemeriksaan tata bahasa, koreksi tata bahasa, dan pengubahan kata-kata.

Beberapa API AI bawaan tersedia di uji coba origin dan versi stabil Chrome. API eksploratif dan API tahap awal tersedia untuk peserta Program Pratinjau Awal (EPP).

Melihat pratinjau fitur baru

Kami memerlukan masukan Anda untuk membentuk API guna membantu memenuhi kasus penggunaan Anda, dan menginformasikan diskusi kami dengan vendor browser lain untuk standardisasi.

Bergabunglah dengan EPP untuk memberikan masukan tentang ide AI bawaan tahap awal, dan temukan peluang untuk menguji API yang sedang dalam proses melalui pembuatan prototipe lokal.

Upaya standardisasi

Kami berupaya menstandardisasi semua API ini untuk kompatibilitas lintas browser.

Language Detector API dan Translator API telah diadopsi oleh W3C WebML Working Group. Kami telah meminta Mozilla dan WebKit untuk memberikan posisi standar mereka.

Summarizer API, Writer API, dan Rewriter API juga telah diadopsi oleh W3C WebML Working Group. Kami telah meminta Mozilla dan WebKit untuk memberikan posisi standar mereka.