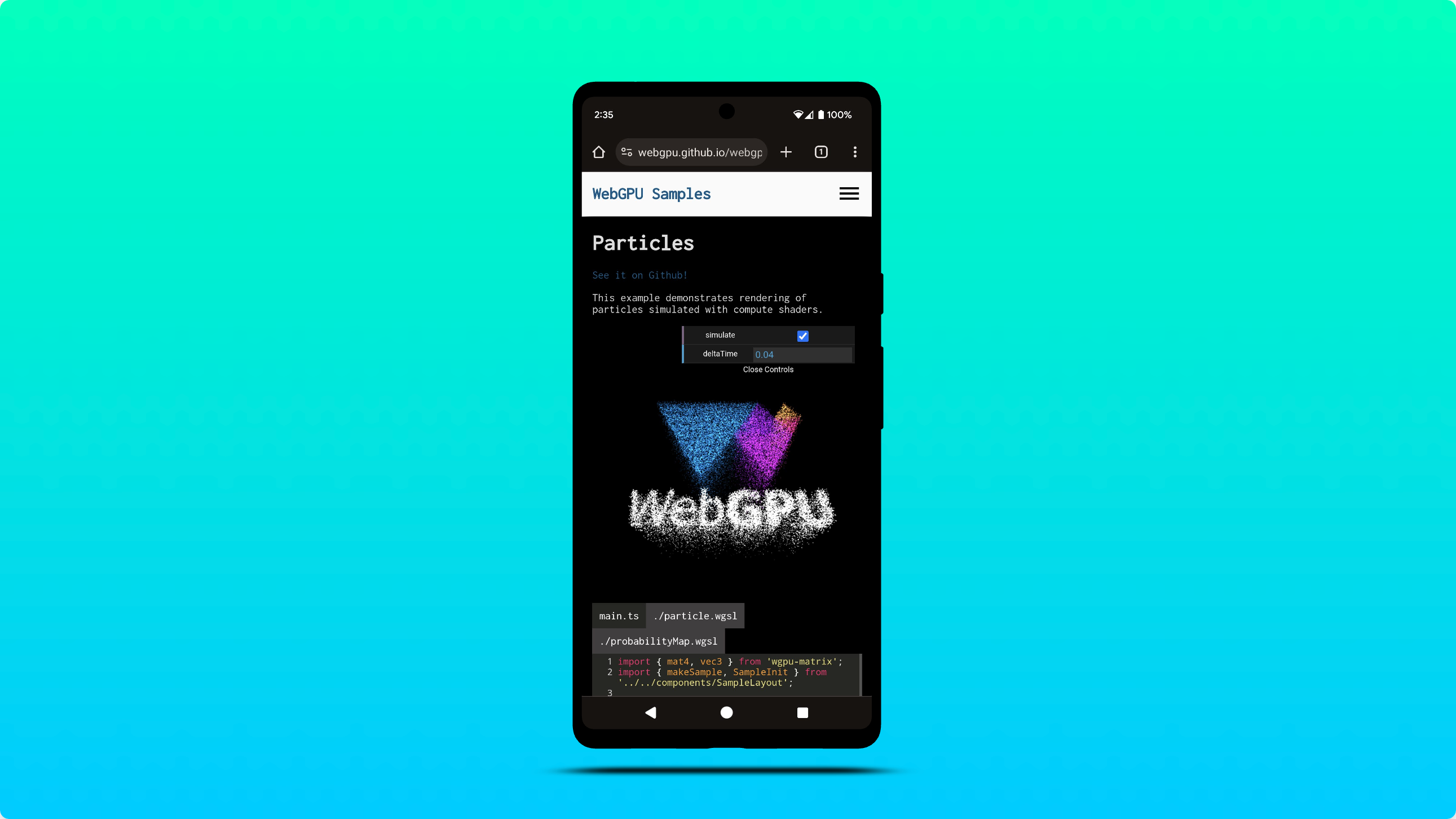

WebGPU unter Android unterstützen

Das Chrome-Team freut sich, bekannt zu geben, dass WebGPU jetzt in Chrome 121 auf Geräten mit Android 12 und höher, die mit Qualcomm- und ARM-GPUs ausgestattet sind, standardmäßig aktiviert ist.

Die Unterstützung wird nach und nach auf eine größere Auswahl an Android-Geräten ausgeweitet, darunter auch Geräte mit Android 11. Diese Erweiterung hängt von weiteren Tests und Optimierungen ab, um eine nahtlose Nutzung auf einer größeren Bandbreite von Hardwarekonfigurationen zu ermöglichen. Weitere Informationen finden Sie unter chromium:1497815.

DXC anstelle von FXC für die Shader-Kompilierung unter Windows verwenden

Chrome nutzt jetzt die Leistung von DXC (DirectX Compiler), um Shader auf Windows D3D12-Computern mit SM6+-Grafikhardware zu kompilieren. Bisher wurde für die Shader-Kompilierung unter Windows FXC (FX Compiler) verwendet. FXC war zwar funktionsfähig, aber es fehlten die in DXC vorhandenen Funktionen und Leistungsoptimierungen.

Erste Tests zeigen, dass die Kompilierungsgeschwindigkeit von Compute-Shadern bei Verwendung von DXC im Vergleich zu FXC durchschnittlich um 20% gesteigert wird.

Zeitstempelabfragen in Compute- und Render-Passes

Mit Zeitstempelabfragen können WebGPU-Anwendungen genau (bis auf die Nanosekunde) messen, wie viel Zeit die Ausführung von Compute- und Render-Passes für ihre GPU-Befehle in Anspruch nimmt. Sie werden häufig verwendet, um Einblicke in die Leistung und das Verhalten von GPU-Arbeitslasten zu erhalten.

Wenn die Funktion "timestamp-query" in einem GPUAdapter verfügbar ist, haben Sie jetzt folgende Möglichkeiten:

- Fordern Sie einen

GPUDevicemit der Funktion"timestamp-query"an. - Erstellen Sie ein

GPUQuerySetvom Typ"timestamp". - Mit

GPUComputePassDescriptor.timestampWritesundGPURenderPassDescriptor.timestampWriteskönnen Sie festlegen, wo Zeitstempelwerte inGPUQuerySetgeschrieben werden. - Lösen Sie Zeitstempelwerte mit

resolveQuerySet()in eineGPUBufferauf. - Lesen Sie Zeitstempelwerte zurück, indem Sie die Ergebnisse aus

GPUBufferin die CPU kopieren. - Zeitstempelwerte als

BigInt64Arraydecodieren.

Sehen Sie sich das folgende Beispiel an und geben Sie dawn:1800 ein.

const adapter = await navigator.gpu.requestAdapter();

if (!adapter.features.has("timestamp-query")) {

throw new Error("Timestamp query feature is not available");

}

// Explicitly request timestamp query feature.

const device = await adapter.requestDevice({

requiredFeatures: ["timestamp-query"],

});

const commandEncoder = device.createCommandEncoder();

// Create a GPUQuerySet which holds 2 timestamp query results: one for the

// beginning and one for the end of compute pass execution.

const querySet = device.createQuerySet({ type: "timestamp", count: 2 });

const timestampWrites = {

querySet,

beginningOfPassWriteIndex: 0, // Write timestamp in index 0 when pass begins.

endOfPassWriteIndex: 1, // Write timestamp in index 1 when pass ends.

};

const passEncoder = commandEncoder.beginComputePass({ timestampWrites });

// TODO: Set pipeline, bind group, and dispatch work to be performed.

passEncoder.end();

// Resolve timestamps in nanoseconds as a 64-bit unsigned integer into a GPUBuffer.

const size = 2 * BigInt64Array.BYTES_PER_ELEMENT;

const resolveBuffer = device.createBuffer({

size,

usage: GPUBufferUsage.QUERY_RESOLVE | GPUBufferUsage.COPY_SRC,

});

commandEncoder.resolveQuerySet(querySet, 0, 2, resolveBuffer, 0);

// Read GPUBuffer memory.

const resultBuffer = device.createBuffer({

size,

usage: GPUBufferUsage.COPY_DST | GPUBufferUsage.MAP_READ,

});

commandEncoder.copyBufferToBuffer(resolveBuffer, 0, resultBuffer, 0, size);

// Submit commands to the GPU.

device.queue.submit([commandEncoder.finish()]);

// Log compute pass duration in nanoseconds.

await resultBuffer.mapAsync(GPUMapMode.READ);

const times = new BigInt64Array(resultBuffer.getMappedRange());

console.log(`Compute pass duration: ${Number(times[1] - times[0])}ns`);

resultBuffer.unmap();

Aus Gründen der Zeitangriffsicherheit werden Zeitstempelabfragen mit einer Auflösung von 100 Mikrosekunden quantisiert. Dies ist ein guter Kompromiss zwischen Genauigkeit und Sicherheit. Im Chrome-Browser können Sie die Zeitstempelquantisierung deaktivieren, indem Sie während der Entwicklung Ihrer App das Flag „WebGPU Developer Features“ unter chrome://flags/#enable-webgpu-developer-features aktivieren. Weitere Informationen finden Sie unter Quantisierung von Zeitstempelabfragen.

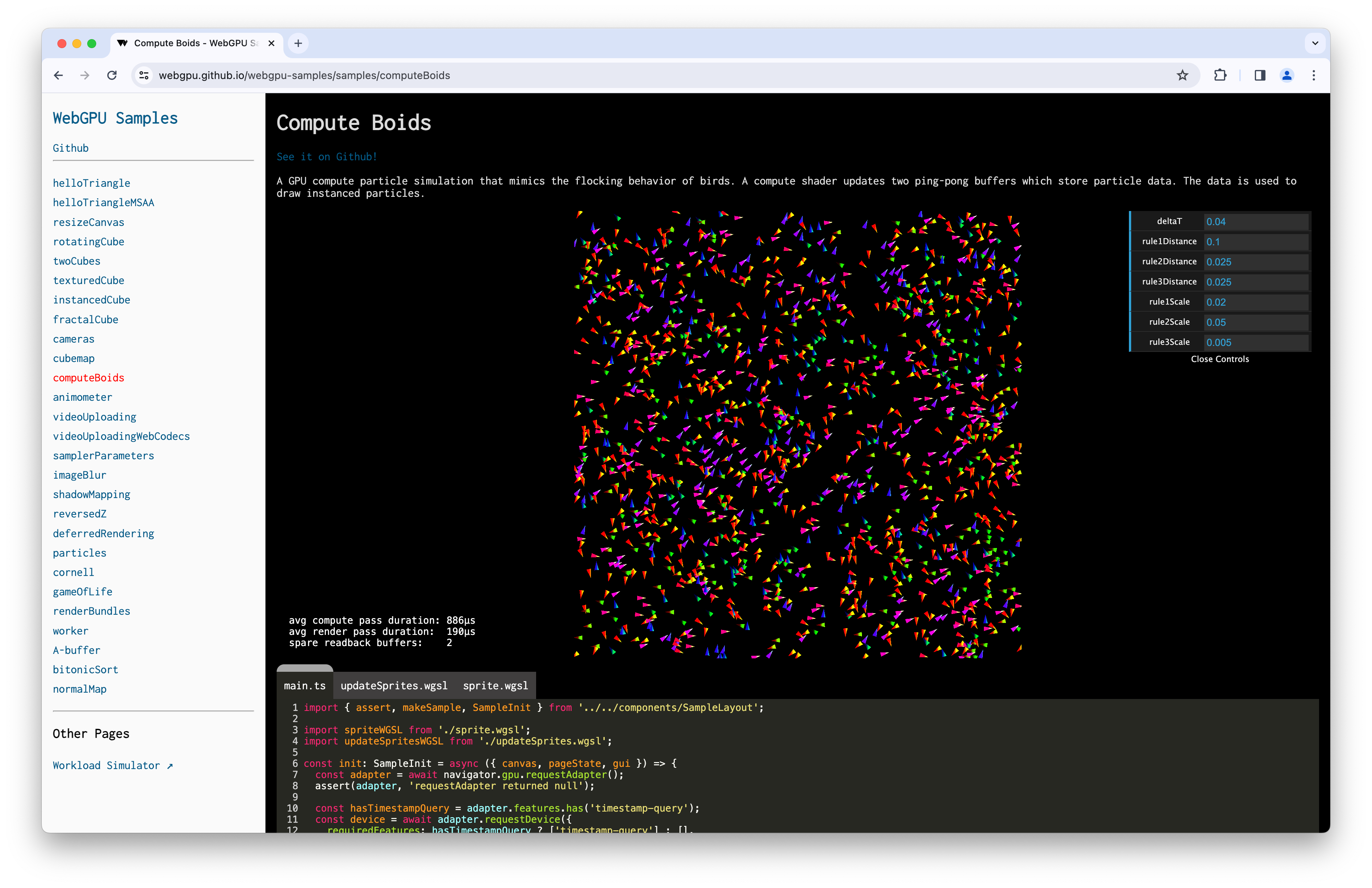

Da GPUs den Zeitstempelzähler gelegentlich zurücksetzen können, was zu unerwarteten Werten wie negativen Deltas zwischen Zeitstempeln führen kann, empfehle ich, sich die git diff-Änderungen anzusehen, die dem folgenden Compute Boids-Beispiel die Unterstützung für Zeitstempelabfragen hinzufügen.

Standardeinstiegspunkte für Shadermodule

Um die Entwicklerfreundlichkeit zu verbessern, können Sie jetzt beim Erstellen einer Compute- oder Render-Pipeline das entryPoint Ihres Shader-Moduls weglassen. Wenn im Shader-Code kein eindeutiger Einstiegspunkt für die Shader-Phase gefunden wird, wird ein GPUValidationError ausgelöst. Sehen Sie sich das folgende Beispiel und Problem dawn:2254 an.

const code = `

@vertex fn vertexMain(@builtin(vertex_index) i : u32) ->

@builtin(position) vec4f {

const pos = array(vec2f(0, 1), vec2f(-1, -1), vec2f(1, -1));

return vec4f(pos[i], 0, 1);

}

@fragment fn fragmentMain() -> @location(0) vec4f {

return vec4f(1, 0, 0, 1);

}`;

const module = myDevice.createShaderModule({ code });

const format = navigator.gpu.getPreferredCanvasFormat();

const pipeline = await myDevice.createRenderPipelineAsync({

layout: "auto",

vertex: { module, entryPoint: "vertexMain" },

fragment: { module, entryPoint: "fragmentMain", targets: [{ format }] },

vertex: { module },

fragment: { module, targets: [{ format }] },

});

Unterstützung von Display P3 als GPUExternalTexture-Farbraum

Sie können jetzt den "display-p3"-Zielfarbraum festlegen, wenn Sie eine GPUExternalTexture aus HDR-Videos mit importExternalTexture() importieren. Weitere Informationen zu Farbräumen in WebGPU Sehen Sie sich das folgende Beispiel und das Problem chromium:1330250 an.

// Create texture from HDR video.

const video = document.querySelector("video");

const texture = myDevice.importExternalTexture({

source: video,

colorSpace: "display-p3",

});

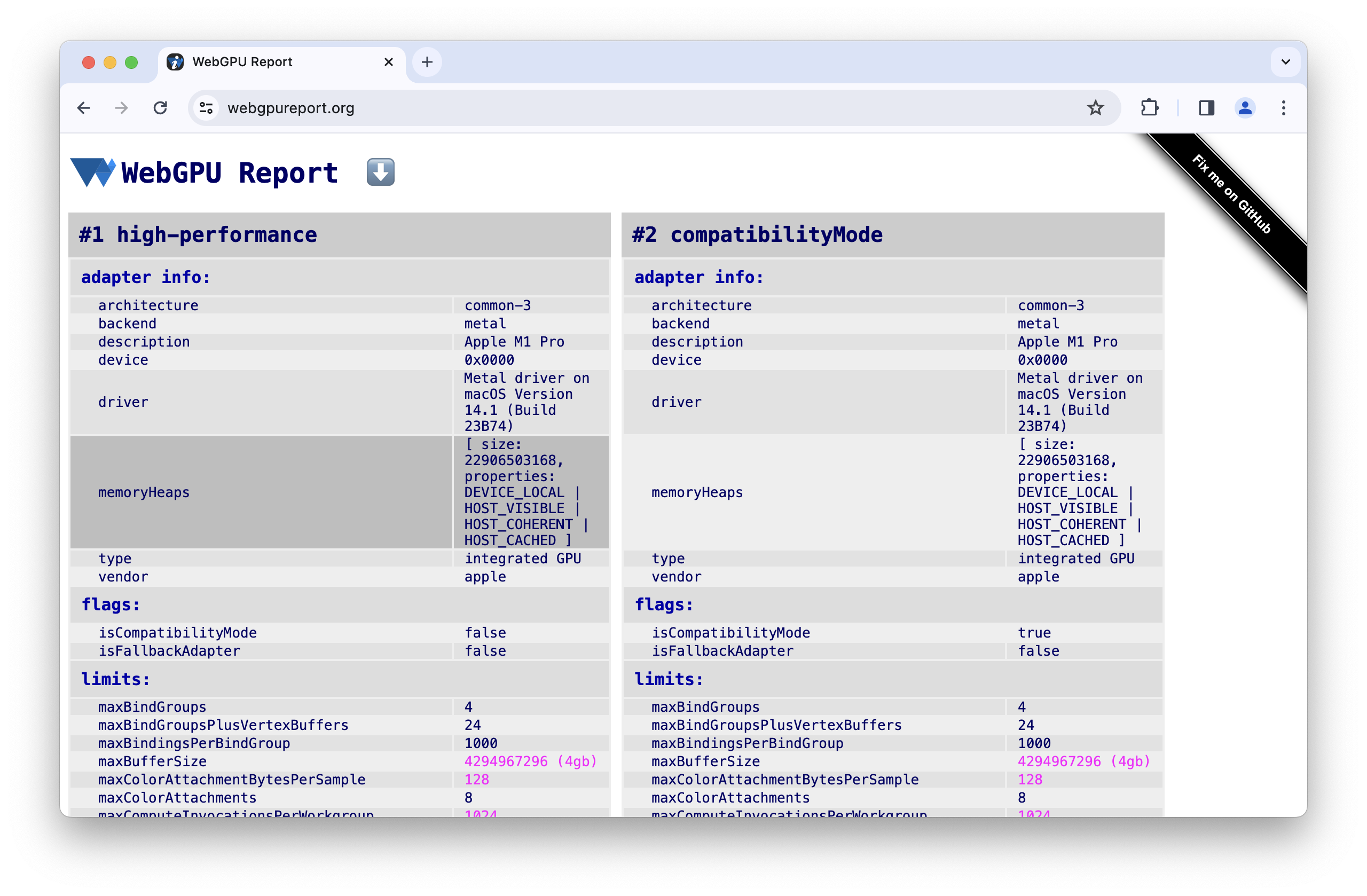

Informationen zu Speicher-Heaps

Damit Sie Speicherbeschränkungen bei der Zuweisung großer Mengen während der Entwicklung Ihrer App besser vorhersehen können, werden in requestAdapterInfo() jetzt memoryHeaps-Informationen wie die Größe und der Typ der auf dem Adapter verfügbaren Speicher-Heaps angezeigt. Diese experimentelle Funktion ist nur verfügbar, wenn das Flag „WebGPU Developer Features“ unter chrome://flags/#enable-webgpu-developer-features aktiviert ist. Sehen Sie sich das folgende Beispiel und Problem dawn:2249 an.

const adapter = await navigator.gpu.requestAdapter();

const adapterInfo = await adapter.requestAdapterInfo();

for (const { size, properties } of adapterInfo.memoryHeaps) {

console.log(size); // memory heap size in bytes

if (properties & GPUHeapProperty.DEVICE_LOCAL) { /* ... */ }

if (properties & GPUHeapProperty.HOST_VISIBLE) { /* ... */ }

if (properties & GPUHeapProperty.HOST_COHERENT) { /* ... */ }

if (properties & GPUHeapProperty.HOST_UNCACHED) { /* ... */ }

if (properties & GPUHeapProperty.HOST_CACHED) { /* ... */ }

}

Dawn-Updates

Die Methoden HasWGSLLanguageFeature und EnumerateWGSLLanguageFeatures für wgpu::Instance wurden hinzugefügt, um WGSL-Sprachfunktionen zu verarbeiten. Siehe Problem dawn:2260.

Mit der nicht standardmäßigen Funktion wgpu::Feature::BufferMapExtendedUsages können Sie einen GPU-Puffer mit wgpu::BufferUsage::MapRead oder wgpu::BufferUsage::MapWrite und einem beliebigen anderen wgpu::BufferUsage erstellen. Sehen Sie sich das folgende Beispiel und das Problem dawn:2204 an.

wgpu::BufferDescriptor descriptor = {

.size = 128,

.usage = wgpu::BufferUsage::MapWrite | wgpu::BufferUsage::Uniform

};

wgpu::Buffer uniformBuffer = device.CreateBuffer(&descriptor);

uniformBuffer.MapAsync(wgpu::MapMode::Write, 0, 128,

[](WGPUBufferMapAsyncStatus status, void* userdata)

{

wgpu::Buffer* buffer = static_cast<wgpu::Buffer*>(userdata);

memcpy(buffer->GetMappedRange(), data, sizeof(data));

},

&uniformBuffer);

Die folgenden Funktionen wurden dokumentiert: ANGLE Texture Sharing, D3D11 multithread protected, Implicit Device Synchronization, Norm16 texture formats, Timestamp Query Inside Passes, Pixel Local Storage, Shader Features und Multi Planar Formats.

Das Chrome-Team hat ein offizielles GitHub-Repository für Dawn erstellt.

Dies sind nur einige der wichtigsten Neuerungen. Vollständige Liste der Commits

Neues zu WebGPU

Eine Liste aller Themen, die in der Reihe Neu in WebGPU behandelt wurden.

Chrome 143

- Swizzle-Vorgang für Texturkomponenten

- Entfernen der schreibgeschützten Speichertexturverwendung für bgra8unorm

- Aktualisierungen für Dawn

Chrome 142

Chrome 141

- Tint IR completed (Färbung – IR abgeschlossen)

- Analyse von Ganzzahlbereichen im WGSL-Compiler

- SPIR-V 1.4-Update für das Vulkan-Backend

- Aktualisierungen für Dawn

Chrome 140

- Geräteanfragen verbrauchen Adapter

- Abkürzung für die Verwendung von Textur, wenn die Texturansicht verwendet wird

- WGSL-Funktion „textureSampleLevel“ unterstützt 1D-Texturen

- Einstellung der Verwendung von schreibgeschützten bgra8unorm-Speichertexturen

- Entfernen des GPUAdapter-Attributs „isFallbackAdapter“

- Aktualisierungen für Dawn

Chrome 139

- Unterstützung von 3D-Texturen für BC- und ASTC-komprimierte Formate

- Neue Funktion „core-features-and-limits“

- Ursprungstest für den WebGPU-Kompatibilitätsmodus

- Aktualisierungen für Dawn

Chrome 138

- Kurzform für die Verwendung des Puffers als Bindungsressource

- Änderungen der Größenanforderungen für Puffer, die bei der Erstellung zugeordnet werden

- Architekturbericht für aktuelle GPUs

- GPUAdapter-Attribut „isFallbackAdapter“ wird nicht mehr unterstützt

- Aktualisierungen für Dawn

Chrome 137

- Texturansicht für die Bindung von „externalTexture“ verwenden

- Puffer werden ohne Angabe von Offsets und Größe kopiert

- WGSL-Funktion „workgroupUniformLoad“ mit Zeiger auf atomaren Typ

- GPUAdapterInfo-Attribut „powerPreference“

- Entfernen des Attributs „compatibilityMode“ für GPURequestAdapterOptions

- Aktualisierungen für Dawn

Chrome 136

- GPUAdapterInfo-Attribut „isFallbackAdapter“

- Verbesserte Shader-Kompilierungszeit unter D3D12

- Canvas-Bilder speichern und kopieren

- Einschränkungen für den Kompatibilitätsmodus für die Analyse der Anzeigenwirkung

- Aktualisierungen für Dawn

Chrome 135

- Erstellen von Pipeline-Layouts mit Null-Bindungsgruppen-Layout zulassen

- Zulassen, dass Viewports über die Grenzen der Renderziele hinausgehen

- Einfacherer Zugriff auf den experimentellen Kompatibilitätsmodus unter Android

- Entfernen des Limits „maxInterStageShaderComponents“

- Aktualisierungen für Dawn

Chrome 134

- Arbeitslasten für maschinelles Lernen mit Untergruppen verbessern

- Unterstützung für float-filterbare Texturtypen als blendable entfernen

- Aktualisierungen für Dawn

Chrome 133

- Zusätzliche unorm8x4-bgra- und 1-Komponenten-Vertexformate

- Anfordern unbekannter Limits mit undefiniertem Wert zulassen

- Änderungen an den WGSL-Ausrichtungsregeln

- WGSL-Leistungssteigerungen mit „discard“

- VideoFrame.displaySize für externe Texturen verwenden

- Bilder mit nicht standardmäßigen Ausrichtungen mit copyExternalImageToTexture verarbeiten

- Für die Entwicklung optimiert

- Kompatibilitätsmodus mit „featureLevel“ aktivieren

- Bereinigung experimenteller Untergruppenfunktionen

- maxInterStageShaderComponents-Limit einstellen

- Aktualisierungen für Dawn

Chrome 132

- Nutzung der Texturansicht

- Mischen von 32-Bit-Gleitkomma-Texturen

- GPUDevice-Attribut „adapterInfo“

- Beim Konfigurieren des Canvas-Kontexts mit einem ungültigen Format wird ein JavaScript-Fehler ausgegeben

- Einschränkungen für das Filtern von Samplern für Texturen

- Erweiterte Untergruppentests

- Für die Entwicklung optimiert

- Experimentelle Unterstützung für normalisierte 16‑Bit-Texturformate

- Aktualisierungen für Dawn

Chrome 131

- Clip-Distanzen in WGSL

- GPUCanvasContext.getConfiguration()

- Punkt- und Linien-Grundtypen dürfen keine Tiefenabweichung haben

- Integrierte Funktionen für inklusive Scans für Untergruppen

- Experimentelle Unterstützung für indirekte Multi-Draw-Funktion

- Kompilierungsoption für Shadermodule „strict math“

- Entfernen von GPUAdapter.requestAdapterInfo()

- Aktualisierungen für Dawn

Chrome 130

- Zusammenführen von zwei Quellen

- Verbesserungen bei der Shader-Kompilierungszeit auf Metal

- Einstellung von GPUAdapter.requestAdapterInfo()

- Aktualisierungen für Dawn

Chrome 129

- HDR-Unterstützung mit Canvas-Tone-Mapping-Modus

- Erweiterte Unterstützung für Untergruppen

- Aktualisierungen für Dawn

Chrome 128

- Mit Untergruppen experimentieren

- Festlegen des Tiefen-Bias für Linien und Punkte wird eingestellt

- Warnung zu nicht abgefangenen Fehlern in den Entwicklertools ausblenden, wenn preventDefault

- WGSL-Interpolation zuerst und entweder

- Aktualisierungen für Dawn

Chrome 127

- Experimentelle Unterstützung für OpenGL ES unter Android

- GPUAdapter-Attribut „info“

- Verbesserungen der WebAssembly-Interop-Funktion

- Verbesserte Fehlerbehebung bei der Befehlscodierung

- Aktualisierungen für Dawn

Chrome 126

- maxTextureArrayLayers-Limit erhöhen

- Optimierung des Pufferuploads für das Vulkan-Backend

- Verbesserungen bei der Shader-Kompilierungszeit

- Eingereichte Befehlspuffer müssen eindeutig sein

- Aktualisierungen für Dawn

Chrome 125

- Untergruppen (Funktion in der Entwicklung)

- In Scheibe einer 3D-Textur rendern

- Aktualisierungen für Dawn

Chrome 124

- Schreibgeschützte und Lese-/Schreibspeicher-Texturen

- Unterstützung von Service Workern und Shared Workers

- Neue Attribute für Adapterinformationen

- Diverse Fehlerkorrekturen

- Aktualisierungen für Dawn

Chrome 123

- Unterstützung von integrierten DP4a-Funktionen in WGSL

- Uneingeschränkte Zeigerparameter in WGSL

- Syntax-Zucker für das Dereferenzieren von Composites in WGSL

- Separater schreibgeschützter Status für Schablonen- und Tiefenaspekte

- Aktualisierungen für Dawn

Chrome 122

- Reichweite mit dem Kompatibilitätsmodus erhöhen (Funktion in der Entwicklung)

- Limit für „maxVertexAttributes“ erhöhen

- Aktualisierungen für Dawn

Chrome 121

- WebGPU unter Android unterstützen

- DXC anstelle von FXC für die Shader-Kompilierung unter Windows verwenden

- Zeitstempelabfragen in Compute- und Render-Passes

- Standardeinstiegspunkte für Shader-Module

- display-p3 als GPUExternalTexture-Farbraum unterstützen

- Informationen zu Speicher-Heaps

- Aktualisierungen für Dawn

Chrome 120

- Unterstützung von 16‑Bit-Gleitkommawerten in WGSL

- An die Grenzen gehen

- Änderungen am Tiefen-Stencil-Status

- Aktualisierungen der Adapterinformationen

- Quantisierung von Zeitstempelabfragen

- Funktionen für den Frühjahrsputz

Chrome 119

- Filterbare 32-Bit-Gleitkomma-Texturen

- unorm10-10-10-2-Vertexformat

- rgb10a2uint-Texturformat

- Aktualisierungen für Dawn

Chrome 118

- Unterstützung von HTMLImageElement und ImageData in

copyExternalImageToTexture() - Experimentelle Unterstützung für Lese-/Schreib- und schreibgeschützte Speichertexturen

- Aktualisierungen für Dawn

Chrome 117

- Vertex-Puffer zurücksetzen

- Bindungsgruppe aufheben

- Fehler bei der asynchronen Pipelineerstellung unterdrücken, wenn das Gerät verloren geht

- Aktualisierungen bei der Erstellung von SPIR-V-Shadermodulen

- Für die Entwicklung optimiert

- Pipelines mit automatisch generiertem Layout im Cache speichern

- Aktualisierungen für Dawn

Chrome 116

- WebCodecs-Integration

- Verlorenes Gerät, das von GPUAdapter

requestDevice()zurückgegeben wurde - Videowiedergabe flüssig halten, wenn

importExternalTexture()aufgerufen wird - Einhaltung der Spezifikationen

- Für die Entwicklung optimiert

- Aktualisierungen für Dawn

Chrome 115

- Unterstützte WGSL-Spracherweiterungen

- Experimentelle Unterstützung für Direct3D 11

- Standardmäßig diskrete GPU bei Stromversorgung über Wechselstrom

- Für die Entwicklung optimiert

- Aktualisierungen für Dawn

Chrome 114

- JavaScript optimieren

- „getCurrentTexture()“ für nicht konfigurierte Canvas-Elemente löst „InvalidStateError“ aus

- WGSL-Updates

- Aktualisierungen für Dawn