Data publikacji: 14 maja 2024 r., ostatnia aktualizacja: 20 maja 2024 r.

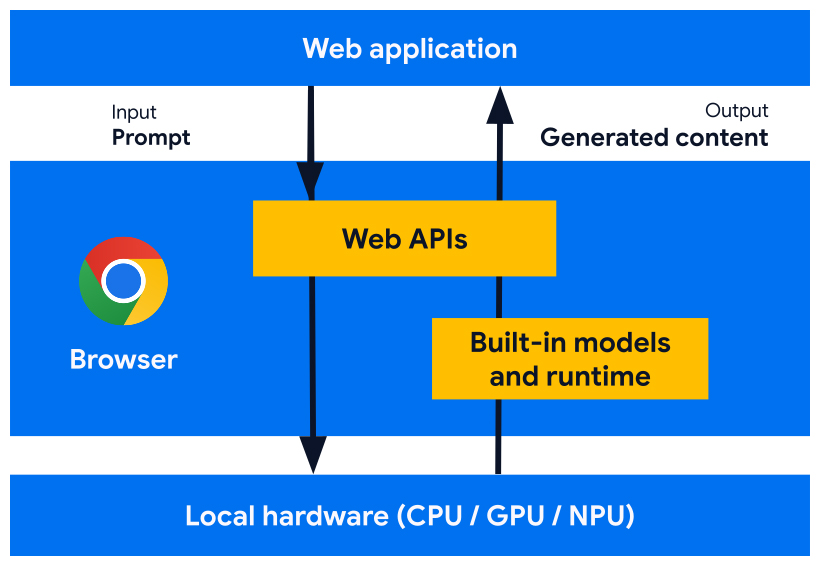

Opracowujemy interfejsy API platformy internetowej i funkcje przeglądarki zaprojektowane do współpracy z modelami AI, modelami eksperckimi i dużymi modelami językowymi (LLM) wbudowanymi w przeglądarkę. Dzięki wbudowanej AI Twoja witryna lub aplikacja internetowa może wykonywać zadania oparte na AI bez konieczności wdrażania modeli, zarządzania nimi ani samodzielnego hostowania.

Poznaj zalety wbudowanej AI, nasz plan wdrożenia i dowiedz się, jak zacząć korzystać z tych narzędzi.

Jeśli dopiero zaczynasz przygodę z AI w internecie, zapoznaj się z naszym słowniczkiem pojęć związanych z AI w internecie.

Korzyści z wbudowanej AI dla programistów stron internetowych

Dzięki wbudowanej AI przeglądarka udostępnia modele podstawowe i eksperckie oraz nimi zarządza.

Wbudowana AI zapewnia te korzyści:

- Łatwość wdrażania: przeglądarka rozpowszechnia modele, uwzględniając możliwości urządzenia, i zarządza aktualizacjami. Oznacza to, że nie musisz pobierać ani aktualizować dużych modeli przez sieć. Nie musisz rozwiązywać problemów związanych z usuwaniem danych z pamięci, budżetem pamięci środowiska wykonawczego, kosztami obsługi i innymi wyzwaniami.

- Dostęp do akceleracji sprzętowej: środowisko wykonawcze AI w przeglądarce jest zoptymalizowane pod kątem maksymalnego wykorzystania dostępnego sprzętu, niezależnie od tego, czy jest to GPU, NPU czy CPU. Dzięki temu aplikacja może działać jak najlepiej na każdym urządzeniu.

Zalety działania po stronie klienta

Dzięki wbudowanej AI możesz wykonywać działania AI po stronie klienta, co oznacza, że uzyskasz te korzyści:

- Lokalne przetwarzanie danych wrażliwych: AI po stronie klienta może zwiększyć ochronę prywatności. Jeśli na przykład pracujesz z danymi wrażliwymi, możesz oferować użytkownikom funkcje AI z pełnym szyfrowaniem.

- Szybkie działanie: w niektórych przypadkach rezygnacja z wysyłania danych do serwera i z powrotem oznacza, że możesz oferować niemal natychmiastowe wyniki. AI po stronie klienta może decydować o tym, czy dana funkcja będzie przydatna, czy też nie.

- Większy dostęp do AI: urządzenia użytkowników mogą przejąć część obciążenia związanego z przetwarzaniem danych w zamian za większy dostęp do funkcji. Jeśli na przykład oferujesz funkcje AI premium, możesz udostępnić ich podgląd za pomocą AI po stronie klienta, aby potencjalni klienci mogli zobaczyć korzyści z Twojego produktu bez dodatkowych kosztów. Takie hybrydowe podejście może też pomóc w zarządzaniu kosztami wnioskowania, zwłaszcza w przypadku często używanych ścieżek użytkownika.

- Korzystanie z AI w trybie offline: użytkownicy mogą korzystać z funkcji AI nawet bez połączenia z internetem. Oznacza to, że Twoje witryny i aplikacje internetowe mogą działać zgodnie z oczekiwaniami w trybie offline lub przy zmiennym połączeniu.

Hybrydowa AI: po stronie klienta i po stronie serwera

Sztuczna inteligencja po stronie klienta może obsługiwać wiele przypadków użycia, ale niektóre z nich wymagają obsługi po stronie serwera. AI po stronie serwera to świetne rozwiązanie w przypadku dużych modeli, które może obsługiwać szerszy zakres platform i urządzeń.

Jeśli Twoja aplikacja wymaga:

- Złożoność: konkretne, przystępne przypadki użycia łatwiej obsługiwać za pomocą AI na urządzeniu. W przypadku złożonych przypadków użycia rozważ wdrożenie po stronie serwera.

- Odporność: domyślnie korzystaj z modeli po stronie serwera, a z modeli na urządzeniu, gdy urządzenie jest offline lub ma niestabilne połączenie.

- Płynne przełączanie: wprowadzenie przeglądarek z wbudowaną AI zajmie trochę czasu, niektóre modele mogą być niedostępne, a starsze lub mniej wydajne urządzenia mogą nie spełniać wymagań sprzętowych, aby optymalnie uruchamiać wszystkie modele. oferować tym użytkownikom AI po stronie serwera.

Jeśli na przykład używasz wbudowanego interfejsu API Prompt, jest on dostępny tylko w rozszerzeniach do Chrome w systemach Windows, macOS i Linux. Aby mieć pewność, że wszyscy użytkownicy mogą korzystać z funkcji AI, skonfiguruj architekturę hybrydową z Firebase AI Logic.

Dostęp do wbudowanej AI

Dostęp do wbudowanych funkcji AI można uzyskać głównie za pomocą interfejsów API zadań, takich jak interfejs Translator API lub Summarizer API. Interfejsy Task API są przeznaczone do przeprowadzania wnioskowania na podstawie najlepszego modelu dla danego zadania, niezależnie od tego, czy jest to model językowy czy model ekspercki.

Kiedy używać wbudowanej AI

Oto kilka sposobów, w jakie wbudowana AI może przynieść korzyści Tobie i Twoim użytkownikom:

- Konsumowanie treści z użyciem AI: w tym podsumowywanie, tłumaczenie, kategoryzowanie, charakteryzowanie i dostarczanie wiedzy.

- Tworzenie treści z pomocą AI: np. pomoc w pisaniu, korekta, poprawianie gramatyki i przeformułowywanie.

Niektóre wbudowane interfejsy API AI są dostępne w stabilnej wersji Chrome i w ramach wersji próbnych origin. Interfejsy API w fazie eksploracyjnej i wczesnej są dostępne dla uczestników programu wczesnego dostępu.

Wyświetlanie podglądu nowych funkcji

Potrzebujemy Twoich opinii, aby dostosować interfejsy API do Twoich potrzeb i ułatwić nam rozmowy z innymi dostawcami przeglądarek na temat standaryzacji.

Dołącz do programu EPP, aby przekazywać opinie na temat pomysłów na wbudowaną AI na wczesnym etapie rozwoju i odkrywać możliwości testowania interfejsów API w trakcie prac nad nimi za pomocą lokalnego prototypowania.

Działania normalizacyjne

Pracujemy nad ujednoliceniem wszystkich tych interfejsów API, aby zapewnić ich zgodność z różnymi przeglądarkami.

Interfejsy Language Detector API i Translator API zostały przyjęte przez grupę roboczą W3C WebML. Poprosiliśmy Mozilla i WebKit o przedstawienie ich stanowisk w sprawie standardów.

Interfejsy Summarizer API, Writer API i Rewriter API zostały również przyjęte przez grupę roboczą W3C WebML. Poprosiliśmy Mozilla i WebKit o przedstawienie ich stanowisk w sprawie standardów.