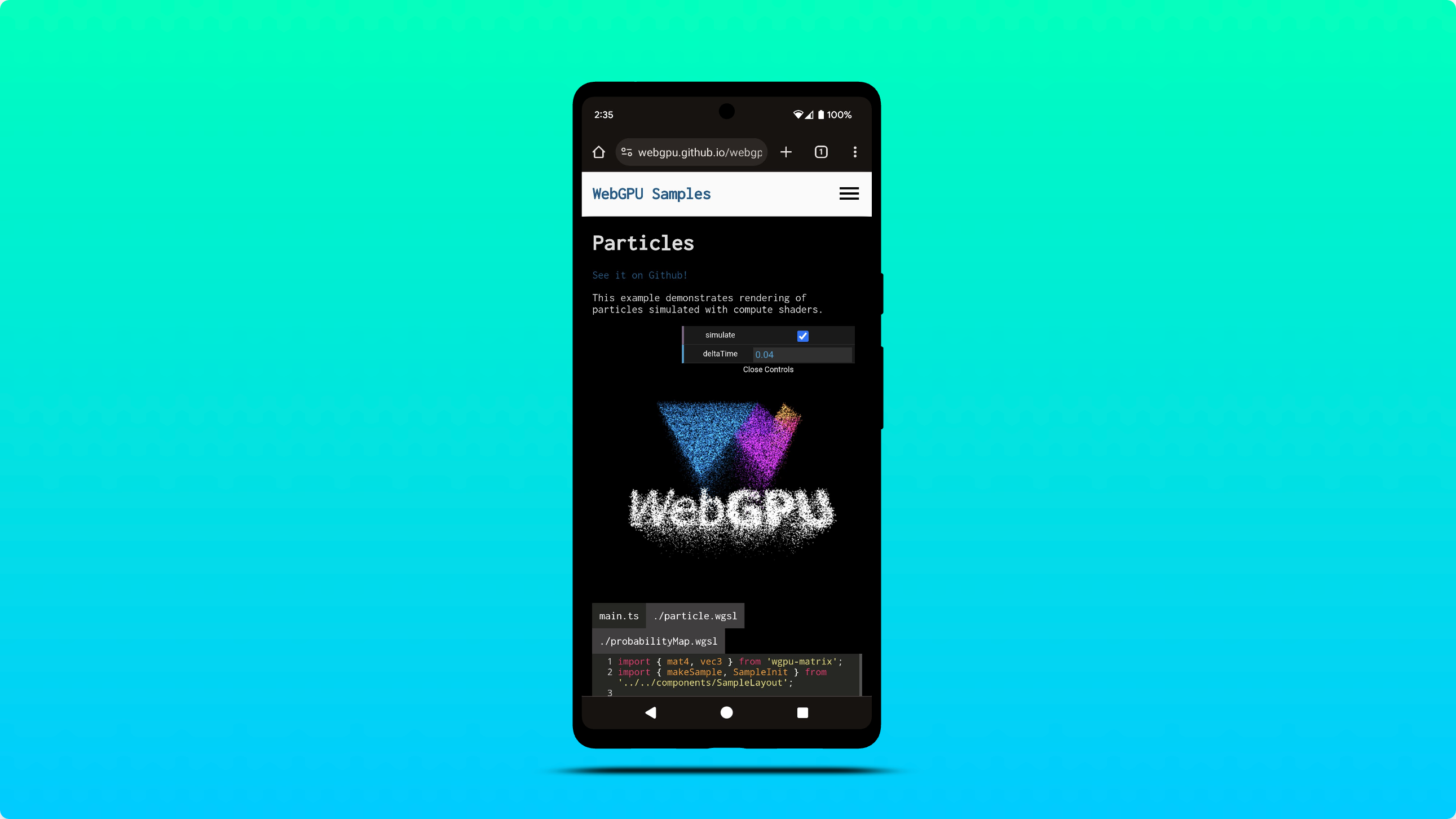

Поддержка WebGPU на Android

Команда Chrome рада сообщить, что функция WebGPU теперь включена по умолчанию в Chrome 121 на устройствах под управлением Android 12 и более поздних версий, оснащенных графическими процессорами Qualcomm и ARM.

Поддержка будет постепенно расширяться и охватывать более широкий спектр устройств Android, включая устройства под управлением Android 11 в ближайшем будущем. Это расширение будет зависеть от дальнейшего тестирования и оптимизации для обеспечения бесперебойной работы на более широком диапазоне аппаратных конфигураций. См. проблему chromium:1497815 .

Для компиляции шейдеров в Windows используйте DXC вместо FXC.

Теперь Chrome использует возможности DXC (компилятора DirectX) для компиляции шейдеров на машинах под управлением Windows D3D12, оснащенных графическим оборудованием SM6+. Ранее WebGPU использовал FXC (компилятор FX) для компиляции шейдеров в Windows. Хотя FXC и был функциональным, ему не хватало набора функций и оптимизаций производительности, имеющихся в DXC.

Первоначальные тесты показывают среднее увеличение скорости компиляции вычислительных шейдеров на 20% при использовании DXC по сравнению с FXC.

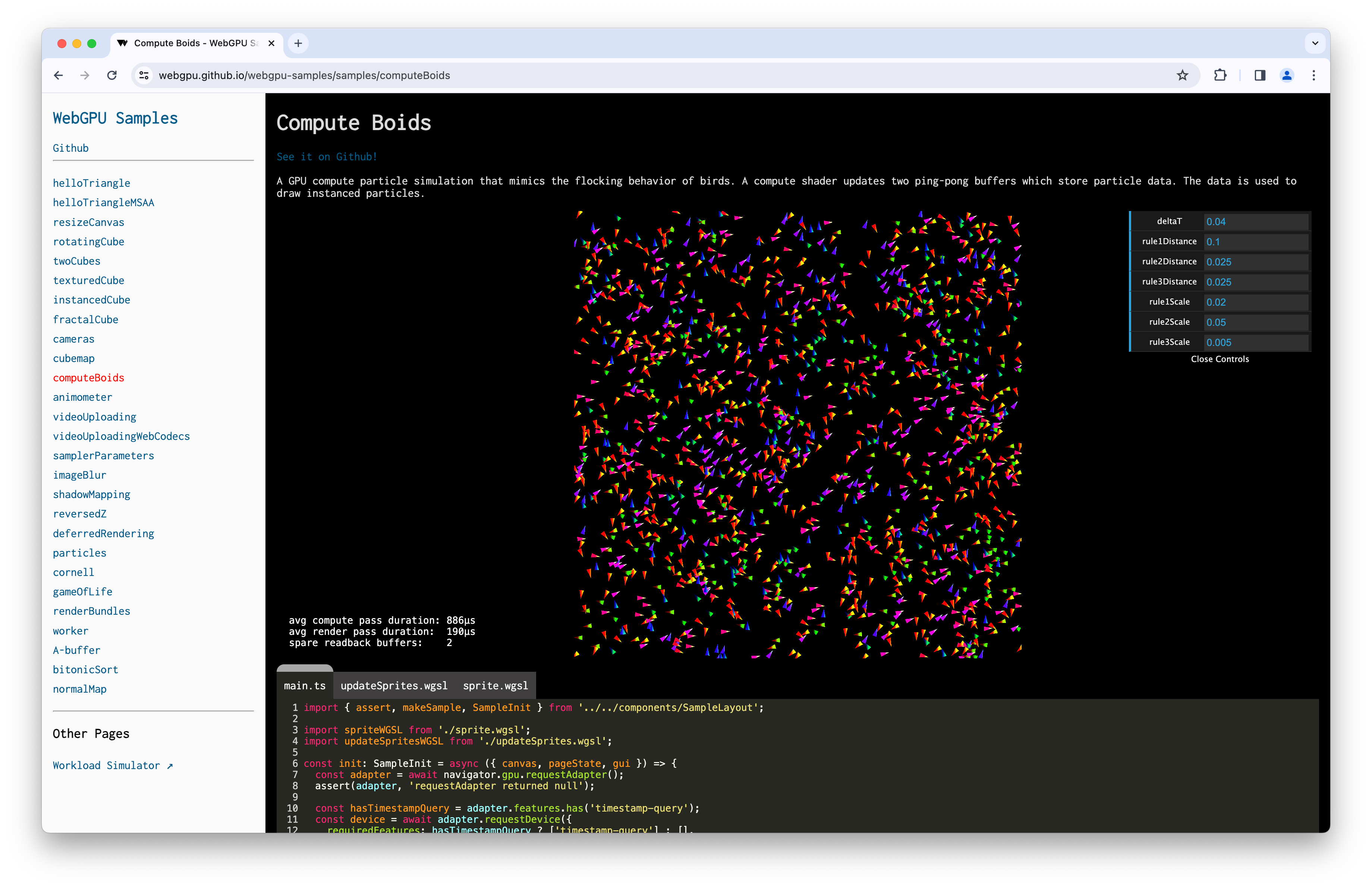

Запросы по временным меткам в вычислительных и рендеринговых проходах

Запросы с использованием временных меток позволяют приложениям WebGPU точно (с точностью до наносекунды) измерять время, необходимое для выполнения вычислительных и рендеринговых проходов с помощью команд GPU. Они широко используются для получения информации о производительности и поведении рабочих нагрузок GPU.

Если в GPUAdapter доступна функция "timestamp-query" , теперь можно выполнять следующие действия:

- Запросите устройство

GPUDeviceс помощью функции"timestamp-query". - Создайте объект

GPUQuerySetтипа"timestamp". - Используйте

GPUComputePassDescriptor.timestampWritesиGPURenderPassDescriptor.timestampWrites, чтобы определить, куда записывать значения временных меток вGPUQuerySet. - Преобразуйте значения временных меток в

GPUBufferс помощьюresolveQuerySet(). - Считывайте значения временных меток, копируя результаты из

GPUBufferв ЦП. - Декодирование значений временных меток в виде массива

BigInt64Array.

См. следующий пример и выпуск dawn:1800 .

const adapter = await navigator.gpu.requestAdapter();

if (!adapter.features.has("timestamp-query")) {

throw new Error("Timestamp query feature is not available");

}

// Explicitly request timestamp query feature.

const device = await adapter.requestDevice({

requiredFeatures: ["timestamp-query"],

});

const commandEncoder = device.createCommandEncoder();

// Create a GPUQuerySet which holds 2 timestamp query results: one for the

// beginning and one for the end of compute pass execution.

const querySet = device.createQuerySet({ type: "timestamp", count: 2 });

const timestampWrites = {

querySet,

beginningOfPassWriteIndex: 0, // Write timestamp in index 0 when pass begins.

endOfPassWriteIndex: 1, // Write timestamp in index 1 when pass ends.

};

const passEncoder = commandEncoder.beginComputePass({ timestampWrites });

// TODO: Set pipeline, bind group, and dispatch work to be performed.

passEncoder.end();

// Resolve timestamps in nanoseconds as a 64-bit unsigned integer into a GPUBuffer.

const size = 2 * BigInt64Array.BYTES_PER_ELEMENT;

const resolveBuffer = device.createBuffer({

size,

usage: GPUBufferUsage.QUERY_RESOLVE | GPUBufferUsage.COPY_SRC,

});

commandEncoder.resolveQuerySet(querySet, 0, 2, resolveBuffer, 0);

// Read GPUBuffer memory.

const resultBuffer = device.createBuffer({

size,

usage: GPUBufferUsage.COPY_DST | GPUBufferUsage.MAP_READ,

});

commandEncoder.copyBufferToBuffer(resolveBuffer, 0, resultBuffer, 0, size);

// Submit commands to the GPU.

device.queue.submit([commandEncoder.finish()]);

// Log compute pass duration in nanoseconds.

await resultBuffer.mapAsync(GPUMapMode.READ);

const times = new BigInt64Array(resultBuffer.getMappedRange());

console.log(`Compute pass duration: ${Number(times[1] - times[0])}ns`);

resultBuffer.unmap();

Из-за опасений по поводу атак по времени запросы с использованием временных меток квантуются с разрешением в 100 микросекунд, что обеспечивает хороший компромисс между точностью и безопасностью. В браузере Chrome вы можете отключить квантование временных меток, включив флаг "WebGPU Developer Features" по адресу chrome://flags/#enable-webgpu-developer-features во время разработки вашего приложения. Подробнее см. раздел "Квантование запросов с временными метками" .

Поскольку графические процессоры могут время от времени сбрасывать счетчик временных меток, что может привести к неожиданным значениям, таким как отрицательная разница между временными метками, я рекомендую вам ознакомиться с изменениями в репозитории Git , которые добавляют поддержку запросов по временным меткам в следующий пример Compute Boids .

Точки входа по умолчанию для модулей шейдеров

Для улучшения удобства работы разработчиков теперь можно опускать точку entryPoint модуля шейдера при создании вычислительного или рендерингового конвейера. Если в коде шейдера не найдена уникальная точка входа для этапа шейдера, будет вызвана ошибка GPUValidationError . См. следующий пример и проблему dawn:2254 .

const code = `

@vertex fn vertexMain(@builtin(vertex_index) i : u32) ->

@builtin(position) vec4f {

const pos = array(vec2f(0, 1), vec2f(-1, -1), vec2f(1, -1));

return vec4f(pos[i], 0, 1);

}

@fragment fn fragmentMain() -> @location(0) vec4f {

return vec4f(1, 0, 0, 1);

}`;

const module = myDevice.createShaderModule({ code });

const format = navigator.gpu.getPreferredCanvasFormat();

const pipeline = await myDevice.createRenderPipelineAsync({

layout: "auto",

vertex: { module, entryPoint: "vertexMain" },

fragment: { module, entryPoint: "fragmentMain", targets: [{ format }] },

vertex: { module },

fragment: { module, targets: [{ format }] },

});

Поддержка display-p3 в качестве цветового пространства GPUExternalTexture

Теперь вы можете задать целевое цветовое пространство "display-p3" при импорте GPUExternalTexture из HDR-видео с помощью importExternalTexture() . Узнайте, как WebGPU обрабатывает цветовые пространства . См. следующий пример и проблему chromium:1330250 .

// Create texture from HDR video.

const video = document.querySelector("video");

const texture = myDevice.importExternalTexture({

source: video,

colorSpace: "display-p3",

});

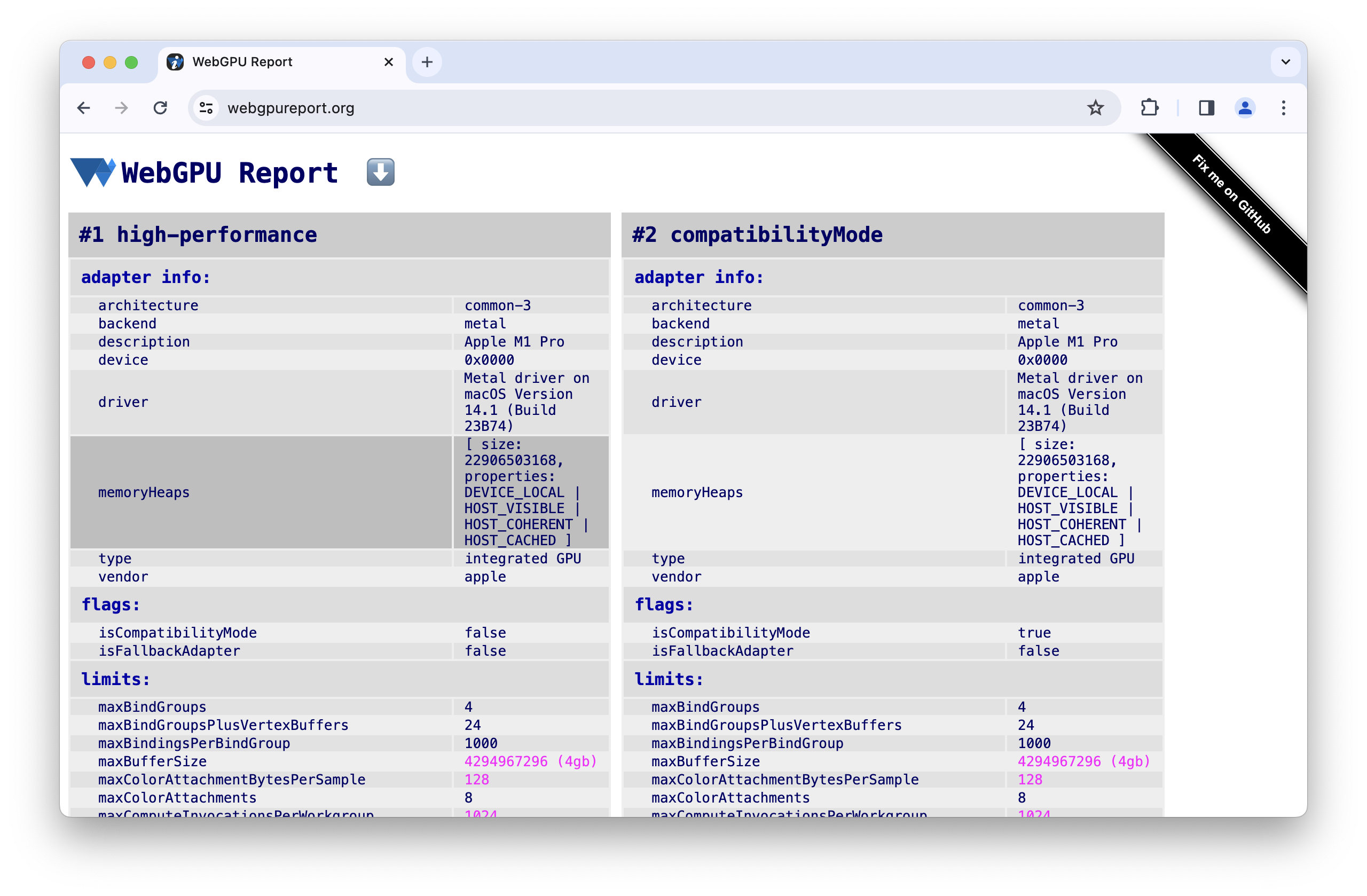

информация о кучах памяти

Чтобы помочь вам предвидеть ограничения памяти при выделении больших объемов памяти во время разработки вашего приложения, requestAdapterInfo() теперь предоставляет информацию memoryHeaps такую как размер и тип доступных куч памяти на адаптере. Эта экспериментальная функция доступна только при включенном флаге "WebGPU Developer Features" по адресу chrome://flags/#enable-webgpu-developer-features . См. следующий пример и проблему dawn:2249 .

const adapter = await navigator.gpu.requestAdapter();

const adapterInfo = await adapter.requestAdapterInfo();

for (const { size, properties } of adapterInfo.memoryHeaps) {

console.log(size); // memory heap size in bytes

if (properties & GPUHeapProperty.DEVICE_LOCAL) { /* ... */ }

if (properties & GPUHeapProperty.HOST_VISIBLE) { /* ... */ }

if (properties & GPUHeapProperty.HOST_COHERENT) { /* ... */ }

if (properties & GPUHeapProperty.HOST_UNCACHED) { /* ... */ }

if (properties & GPUHeapProperty.HOST_CACHED) { /* ... */ }

}

Утренние обновления

Для обработки языковых особенностей WGSL добавлены методы HasWGSLLanguageFeature и EnumerateWGSLLanguageFeatures в wgpu::Instance . См. проблему dawn:2260 .

Нестандартная функция wgpu::Feature::BufferMapExtendedUsages позволяет создавать буфер GPU с помощью wgpu::BufferUsage::MapRead или wgpu::BufferUsage::MapWrite и любого другого wgpu::BufferUsage . См. следующий пример и проблему dawn:2204 .

wgpu::BufferDescriptor descriptor = {

.size = 128,

.usage = wgpu::BufferUsage::MapWrite | wgpu::BufferUsage::Uniform

};

wgpu::Buffer uniformBuffer = device.CreateBuffer(&descriptor);

uniformBuffer.MapAsync(wgpu::MapMode::Write, 0, 128,

[](WGPUBufferMapAsyncStatus status, void* userdata)

{

wgpu::Buffer* buffer = static_cast<wgpu::Buffer*>(userdata);

memcpy(buffer->GetMappedRange(), data, sizeof(data));

},

&uniformBuffer);

Были задокументированы следующие функции: совместное использование текстур ANGLE , многопоточная защита D3D11 , неявная синхронизация устройств , форматы текстур Norm16 , запрос временной метки внутри проходов , локальное хранилище пикселей , особенности шейдеров и многоплоскостные форматы .

Команда Chrome создала официальный репозиторий Dawn на GitHub .

Здесь описаны лишь некоторые из ключевых моментов. Ознакомьтесь с полным списком изменений .

Что нового в WebGPU?

Список всего, что было рассмотрено в серии статей «Что нового в WebGPU» .

Хром 144

- Расширение WGSL subgroup_id

- Расширение WGSL uniform_buffer_standard_layout

- WebGPU на Linux

- Более быстрая запись буфера и текстуры

- Утренние обновления

Хром 143

- Компонент текстуры swizzle

- Удалить использование текстур в хранилище только для чтения bgra8unorm

- Утренние обновления

Хром 142

Хром 141

- Завершено тонирование ИК-излучения

- Анализ целочисленных диапазонов в компиляторе WGSL

- Обновление SPIR-V 1.4 для бэкенда Vulkan

- Утренние обновления

Хром 140

- Устройство запрашивает использование адаптера

- Сокращенная запись для использования текстуры там, где используется представление текстуры.

- WGSL textureSampleLevel поддерживает одномерные текстуры.

- Прекратить использование текстур в режиме только для чтения в bgra8unorm

- Удалите атрибут isFallbackAdapter из списка GPUAdapter.

- Утренние обновления

Хром 139

- Поддержка 3D-текстур для сжатых форматов BC и ASTC.

- Новая функция «Основные функции и ограничения»

- Пробная версия Origin для режима совместимости с WebGPU

- Утренние обновления

Хром 138

- Сокращенная запись для использования буфера в качестве ресурса привязки.

- Изменения требований к размеру буферов, отображаемых при создании.

- Архитектурный отчет для современных графических процессоров.

- Устаревший атрибут isFallbackAdapter для GPUAdapter

- Утренние обновления

Хром 137

- Используйте представление текстуры для привязки внешней текстуры.

- Копирование буферов выполняется без указания смещений и размера.

- Рабочая группа WGSL UniformLoad с использованием указателя на атомарную функцию

- Атрибут powerPreference GPUAdapterInfo

- Удалите атрибут compatibilityMode из GPURequestAdapterOptions.

- Утренние обновления

Хром 136

- Атрибут gPUAdapterInfo isFallbackAdapter

- Улучшения времени компиляции шейдеров в D3D12

- Сохраняйте и копируйте изображения холста.

- Ограничения режима совместимости лифта

- Утренние обновления

Хром 135

- Разрешить создание макета конвейера с макетом группы привязки пустого значения

- Разрешите области просмотра выходить за пределы границ целевых областей рендеринга.

- Упрощенный доступ к экспериментальному режиму совместимости на Android.

- Удалите ограничение maxInterStageShaderComponents.

- Утренние обновления

Хром 134

- Оптимизация рабочих нагрузок машинного обучения с помощью подгрупп

- Удалить поддержку типов текстур с возможностью фильтрации (float filterable texture types) как смешиваемых (blendable).

- Утренние обновления

Хром 133

- Дополнительные форматы unorm8x4-bgra и 1-компонентные вершинные форматы

- Разрешить запрос неизвестных лимитов с неопределенным значением.

- Изменения в правилах выравнивания WGSL

- Повышение производительности WGSL за счет отбрасывания

- Используйте параметр `videoFrame displaySize` для внешних текстур.

- Обработка изображений с нестандартной ориентацией осуществляется с помощью функции copyExternalImageToTexture.

- Улучшение опыта разработчиков

- Включите режим совместимости с помощью featureLevel

- Очистка характеристик экспериментальной подгруппы

- Устаревшее ограничение maxInterStageShaderComponents

- Утренние обновления

Хром 132

- Использование текстурного представления

- смешивание 32-битных текстур с плавающей запятой

- Атрибут GPUDevice adapterInfo

- Настройка контекста холста с недопустимым форматом вызывает ошибку JavaScript.

- Фильтрация ограничений сэмплера для текстур

- Эксперименты с расширенными подгруппами

- Улучшение опыта разработчиков

- Экспериментальная поддержка 16-битных нормализованных форматов текстур.

- Утренние обновления

Хром 131

- Расстояние между клипами в WGSL

- GPUCanvasContext getConfiguration()

- Примитивы точек и линий не должны иметь смещения по глубине.

- Встроенные функции сканирования для подгрупп.

- Экспериментальная поддержка непрямого режима с несколькими вариантами отсчета.

- Параметр компиляции модуля шейдера: строгая математика

- Удалить GPUAdapter requestAdapterInfo()

- Утренние обновления

Хром 130

- Смешивание из двух источников

- Улучшения времени компиляции шейдеров в Metal.

- Функция requestAdapterInfo() объявлена устаревшей.

- Утренние обновления

Хром 129

- Поддержка HDR с режимом тонального отображения холста.

- Расширенная поддержка подгрупп

- Утренние обновления

Хром 128

- Экспериментирование с подгруппами

- Устаревшая настройка смещения глубины для линий и точек.

- Скрыть предупреждение DevTools о незафиксированной ошибке, если используется preventDefault.

- WGSL сначала интерполирует выборку, а затем либо

- Утренние обновления

Хром 127

- Экспериментальная поддержка OpenGL ES на Android

- Информационный атрибут GPUAdapter

- Улучшения взаимодействия с WebAssembly

- Улучшена обработка ошибок кодировщика команд.

- Утренние обновления

Хром 126

- Увеличьте лимит maxTextureArrayLayers.

- Оптимизация загрузки буфера для бэкенда Vulkan.

- Улучшения времени компиляции шейдеров

- Буферы отправленных команд должны быть уникальными.

- Утренние обновления

Хром 125

Хром 124

- Текстуры для хранения данных только для чтения и для чтения и записи

- Поддержка работников сферы услуг и работников, работающих по совместительству

- Новые атрибуты информации об адаптере

- Исправлены ошибки

- Утренние обновления

Хром 123

- Поддержка встроенных функций DP4a в WGSL

- Неограниченные параметры указателей в WGSL

- Синтаксический сахар для разыменования составных элементов в WGSL

- Отдельное состояние только для чтения для параметров трафарета и глубины.

- Утренние обновления

Хром 122

- Расширьте охват аудитории с помощью режима совместимости (функция находится в разработке).

- Увеличьте лимит maxVertexAttributes.

- Утренние обновления

Хром 121

- Поддержка WebGPU на Android

- Для компиляции шейдеров в Windows используйте DXC вместо FXC.

- Запросы по временным меткам в вычислительных и рендеринговых проходах

- Точки входа по умолчанию для модулей шейдеров

- Поддержка display-p3 в качестве цветового пространства GPUExternalTexture

- информация о кучах памяти

- Утренние обновления

Хром 120

- Поддержка 16-битных значений с плавающей запятой в WGSL

- Расширяйте границы возможного

- Изменения в состоянии глубины-шаблона

- Обновления информации об адаптере

- Квантование запросов по временным меткам

- Особенности весенней уборки

Хром 119

- Фильтруемые 32-битные текстуры с плавающей запятой

- unorm10-10-10-2 формат вершин

- формат текстуры rgb10a2uint

- Утренние обновления

Хром 118

- Поддержка HTMLImageElement и ImageData в

copyExternalImageToTexture() - Экспериментальная поддержка текстур для чтения и записи, а также для чтения и только для чтения.

- Утренние обновления

Хром 117

- Неустановленный буфер вершин

- Отключить группу привязки

- Отключение ошибок при создании асинхронного конвейера в случае потери устройства

- Обновления по созданию шейдерных модулей SPIR-V

- Улучшение опыта разработчиков

- Конвейеры кэширования с автоматически генерируемой структурой.

- Утренние обновления

Хром 116

- Интеграция с WebCodecs

-

requestDevice()объекта GPUAdapter возвращает сообщение о потере устройства. - Обеспечьте плавное воспроизведение видео, если вызывается

importExternalTexture() - Соответствие спецификации

- Улучшение опыта разработчиков

- Утренние обновления

Хром 115

- Поддерживаемые языковые расширения WGSL

- Экспериментальная поддержка Direct3D 11

- При подключении к сети переменного тока по умолчанию используется дискретная видеокарта.

- Улучшение опыта разработчиков

- Утренние обновления

Хром 114

- Оптимизировать JavaScript

- Метод getCurrentTexture() на неконфигурированном холсте вызывает ошибку InvalidStateError.

- Обновления WGSL

- Утренние обновления